Data Engineering usando a Modern Data Stack

Carga Horaria: 07 Horas.

O curso apresenta o pipeline de Data Engineering utilizando uma moderna pilha de tecnologias de dados, incluindo Airbyte, Apache Airflow, dbt, Snowflake e Metabase. Durante o curso, os alunos aprenderão a construir e gerenciar pipelines de dados escaláveis e robustos, utilizando essas ferramentas. Eles irão explorar conceitos essenciais de engenharia de dados, como modelagem de dados, transformação de dados.

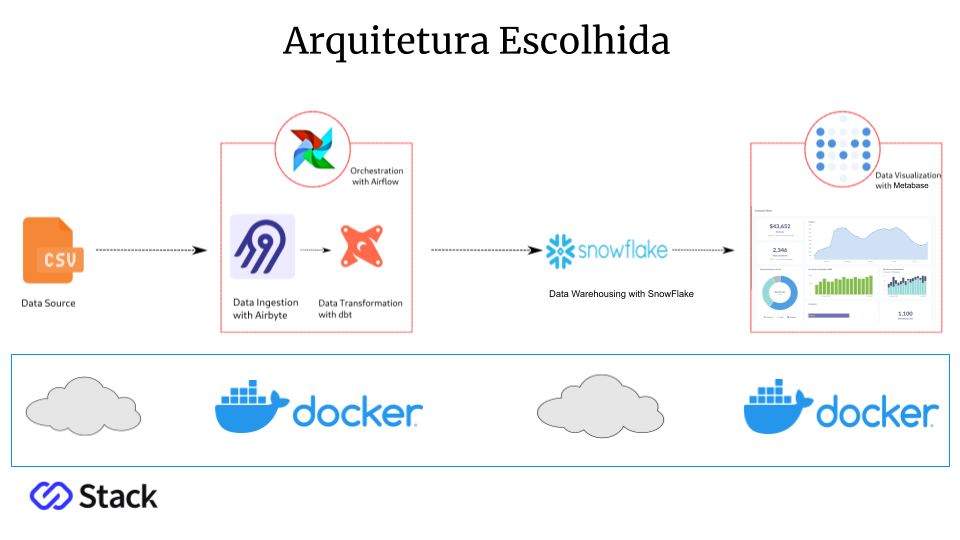

Arquitetura

Módulo 01 - Extração e Carga dos Dados

Introdução à Aplicação

Aula 01 – Entendendo o que vamos construir no projeto

Aula 02 – Conhecendo a estrutura dos nossos dados

Aula 03 – Escolhendo como vamos construir o Pipeline

Aula 04 – Definindo a nossa Arquitetura de dados

Setup do Ambiente de Desenvolvimento

Aula 05 – Conhecendo a ferramenta Gitpod

Aula 06 – Conectando um Workspace no Gtipod em um repositório no Github

Aula 07 – Verificando os recursos de Hardware e Softwares disponíveis

Docker Compose

Aula 08 – Subindo o Airbyte no nosso ambiente via docker

Aula 09 – Subindo o Airflow no nosso ambiente via docker

Aula 10 – Subindo o Metabase no nosso ambiente via docker

Data Warehouse Snowflake

Aula 11 – Criando a Conta, o Warehouse, a Role, o User, o Password, o Database e o Schema no Snowflake

Aula 12 – Verificando o conteúdo das tabelas no Data Warehouse

Aula 13 – Obtendo dos links de conexão e o nome da conta no Snowflake

Pipeline / Extração / Airbyte

Aula 14 – Configurando as Origens dos Dados nos CSVs na Google Cloud

Aula 15 – Configurando o Destino dos Dados no Datawarehouse

Aula 16 – Criando as Conexões de sincronismo dos dados

Aula 17 – Integrando o Airbyte com o Dbt para ativar a transformação automaticamente

Pipeline / Preparação / Airbyte

Aula 18 – Implentando o Local Stage no Ambiente de Desenvolvimento

Aula 19 – Entendendo o Cloud Stage no Ambiente de Produção

Módulo 02 - Transformação dos Dados

Pipeline – Transformação – Dbt

Aula 01 – Criando a Conta na Dbt Cloud

Aula 02 – Criando o repositório dos modelos no Github

Aula 03 – Conectando o Dbt com o Github

Aula 04 – Criando o ambiente e o projeto no Dbt

Aula 05 – Criando o Profile de conexão com o Snowflake

Aula 06 – Desenvolvendo os SQLs dos Modelos Base

Aula 07 – Desenvolvendo o SQL do Modelo Relacionado

Aula 08 – Criando um Schema de Dados

Aula 09 – Visualizando gráficamente o nosso modelo de dados

Aula 10 – Testando a execução do modelo no Dbt

Aula 11 – Verificando a criação das tabelas e views no Snowflake

Aula 12 – Entendendo os Commits, Branches, Pull Requests, Merges no Github

Aula 13 – Obtendo o link de conexão com o Airbyte

Aula 14 – Integrando a sincronia do Airbyte com a transformação do Dbt

Módulo 03 - Orquestração e Visualização dos Dados

Pipeline – Automação – Airflow

Aula 01 – Conectando o Airflow com o Airbyte

Aula 02 – Criando nossa própria network no Docker

Aula 03 – Conectando os containers do Airbyte e do Airflow na nossa network

Aula 04 – Declarando as variáveis de ambiente no Airflow com as conexões do Airbyte

Aula 05 – Criando as Dags de sincronização dos dados

Aula 06 – Definindo a Ordem de Execução das Tasks

Aula 07 – Testando nossa orquestração manualmente

Aula 08 – Criando nosso script de execução completa do pipeline

Aula 09 – Criando o script de configuração do ambiente

Aula 10 – Testando o script de execução completo

Aula 11 – Verificando o status da operação e os dados criados no Data Warehouse

Pipeline / Visualização / Metabase

Aula 12 – Configurando a Conexão com o SnowFlake

Aula 13 – Entendendo como navegar pelos dados e salvar os painéis

Aula 14 – Aprendendo a criar uma question para visualizar os dados

Aula 15 – Criando um Dashboard para juntar os painéis em uma visualização única

Aula 16 – Adicionando as questions no Layout do dashoboard

Aula 17 – Visualizando os Resultados nos gráficos

Aula 18 – Criando uma subscrição de envio automático dos Relatórios por email e pelo Slack

Controle do Versionamento de Código – Github

Aula 19 – Criando repositórios no Github

Aula 20 – Aprendendo como commitar e sincronizar o código nos repositórios

Aula 21 – Entendendo como fazer o fork em outros repositórios para utilizar na nossa aplicação

Aula 22 – Conectando o Github com o Gitpod para desenvolvimento nos workspaces

Aula 23 – Aprendendo a criar uma pagina de profile no Github

Aula 24 – Visualizando nosso portifólio do projeto completo

Encerramento – Considerações Finais

Aula 25 – Fazendo considerações sobre o ambiente de produção

Aula 26 – Introduzindo os gerenciadores de containers

Materiais de Apoio do Curso

Aula 27 – Acessando a Apresentação do Curso

Aula 28 – Acessando os Códigos fonte da aplicação

Aula 29 – Acessando os Links apresentados no curso